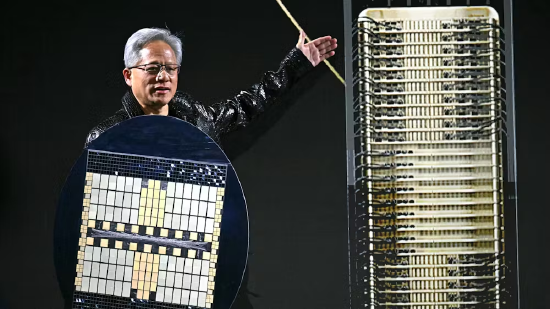

报道:英伟达与大客户终克 Blackwell 芯片部署难题

一年前,英伟达首席执行官黄仁勋向分析师表示,受新一代 Blackwell 人工智能芯片复杂度大幅提升的影响,其客户从前代人工智能服务器芯片向该款芯片的过渡过程颇具 “挑战性”。他称,为提升芯片性能,“服务器机箱、系统架构、硬件配置、供电系统等所有环节都必须做出调整”。

事实上,对于英伟达的一众核心客户而言,推动 Blackwell 服务器的落地与规模化运行,一度是令其倍感棘手的难题。据两名为 OpenAI 及其他大客户提供服务的英伟达员工、一名亲历相关问题处理的Meta公司员工透露,去年大部分时间里,OpenAI、Meta Platforms 及其合作的云服务商始终难以稳定搭建并使用该类系统。而这些人士均表示,相比之下,客户在收到 Blackwell 之前的英伟达人工智能芯片后,数周内便能顺利完成部署并投入使用。

英伟达核心客户在使用其 Blackwell 系列芯片(尤其是 Grace Blackwell 型号)时遭遇的种种难题,似乎并未对这家芯片巨头的业务造成严重冲击。英伟达仍是全球市值最高的企业,市值达 4.24 万亿美元,且目前已基本解决阻碍大客户快速大规模部署该系列芯片的诸多技术问题。

但倘若英伟达未来的新芯片仍出现类似的部署难题,谷歌等竞争对手或将迎来突围良机 —— 只要这些竞品厂商能帮助客户更快地大规模部署芯片,以支撑前沿人工智能技术的研发。此类问题还可能导致难以实现芯片规模化落地的云服务商利润缩水,同时拖慢依托这些芯片研发更先进人工智能模型的 AI 企业的研发进度。

本文内容基于对英伟达、元宇宙员工,以及使用英伟达芯片的云服务商工作人员、为数据中心提供英伟达芯片安装服务的合作伙伴的采访。

对于 OpenAI、Meta这类客户而言,无法按预期规模搭建芯片集群,会限制其训练更大规模人工智能模型的能力。据一名英伟达员工透露,尽管英伟达的客户并未公开抱怨相关问题,但部分客户已私下向英伟达的对接人员表达了不满。

为弥补给受挫客户带来的损失,据一名云服务商高管及一名参与相关协商的英伟达员工透露,英伟达去年针对 Grace Blackwell 芯片的相关问题,向客户提供了部分退款及折扣优惠。

英伟达及云服务商高管均表示,问题主要出在将 72 颗 Grace Blackwell 芯片组联的服务器上 —— 这类设计本是为了让芯片间的通信速度大幅提升,并实现单系统协同运行。该款服务器可与其他服务器互联互通,组成超大规模集群,为人工智能模型的高强度训练提供算力支持。

英伟达一名发言人表示,公司已于 2024 年回应了有关 Grace Blackwell 系统部署进度缓慢的相关质疑,并当时向《信息》杂志发表声明称,该类系统是 “有史以来最先进的计算机”,其落地需要 “与客户开展联合工程研发”。

声明中还提到:“英伟达正与头部云服务商展开深度合作,其团队已成为我们工程研发体系和流程中不可或缺的一部分,相关工程迭代属于行业正常现象,也是我们预期中的环节。”

OpenAI 基础设施业务高管萨钦・卡蒂发表声明称,这家初创企业与英伟达的合作 “正完全按计划为我们的研发路线图提供算力支撑。我们正将所有可用的英伟达芯片全面应用于模型训练和推理环节,这也推动了研发的快速迭代与产品落地,近期我们发布的多款模型便是最好的证明”。

Meta的发言人则拒绝就此置评。

成长的阵痛

有迹象表明,英伟达已从此次的部署难题中吸取了经验教训。公司不仅对现有 Grace Blackwell 系统进行了优化,还针对今年晚些时候即将推出的、基于 Vera Rubin 新一代芯片的服务器开展了改进工作。

据两名参与芯片设计的人士透露,英伟达去年推出了性能更强劲的 Grace Blackwell 芯片升级版,以确保其运行稳定性优于初代产品。他们表示,这款名为 GB300 的升级版芯片,在散热能力、核心材料及连接器品质上均实现了提升。

一名了解具体情况的元宇宙员工称,曾遭遇初代 Grace Blackwell 系统技术故障的Meta工程师发现,新款芯片的组联难度大幅降低。另一名为 OpenAI 提供服务的英伟达员工则透露,OpenAI 等部分客户已对尚未到货的 Grace Blackwell 芯片订单进行调整,转而增订这款升级版产品。

去年秋季,英伟达曾向投资者透露,其 Blackwell 系列芯片的大部分营收已来自经优化的 Grace Blackwell 服务器,公司计划在今年实现该款服务器的大批量交付。

深度依赖英伟达芯片的埃隆・马斯克旗下 xAI 公司,在 Grace Blackwell 服务器的落地应用上似乎走在了行业前列。去年 10 月,该公司已在孟菲斯的数据中心完成了约 10 万颗该款芯片的部署并投入运行,目前尚不清楚这一部署策略是否带来了更优的效果。

先搭建,后测试

英伟达研发 Blackwell 芯片的目标十分明确:帮助客户以远优于前代人工智能芯片的规模和成本效益,开展人工智能模型的训练工作。

在英伟达的前代服务器中,客户最多只能将 8 颗芯片进行组联,且芯片间的通信速度较慢。而 Blackwell 系列芯片的设计核心,是通过在单台服务器内组联 72 颗 Grace Blackwell 芯片,减少不同服务器间的数据传输量,从而释放数据中心的网络资源,支撑更大规模人工智能模型的训练与运行。

据一名曾参与芯片集群搭建的甲骨文员工透露,通过该种方式搭建大规模芯片集群,还能提升基于其训练的人工智能模型的质量,该系统的设计初衷便是减少模型训练过程中常见的硬件故障。

然而,英伟达的这一新设计本身也存在漏洞。将大量芯片高度集成组联,意味着单颗芯片的故障都可能引发连锁反应,导致由数千颗芯片组成的整个集群瘫痪或运行中断。据三名亲历过此类故障的人士透露,企业若要从最近的保存节点重启中断的训练流程,所需成本从数千美元到数百万美元不等。

英伟达 Grace Blackwell 系统的落地从一开始便波折不断。2024 年夏季,芯片设计缺陷导致量产推迟,各类问题开始显现。一年前,首批 Blackwell 芯片交付客户后,服务器机柜又接连出现过热、连接故障等问题,致使微软、亚马逊云科技、谷歌、元宇宙等核心客户纷纷削减订单,转而采购前代芯片。

多家订购了 Grace Blackwell 芯片的云服务商员工表示,他们认为英伟达在相关软硬件尚未完全调试到位的情况下,便向客户进行了交付。

但英伟达一名前高管为公司的这一策略进行了辩护,称 72 芯组联的 Grace Blackwell 服务器遭遇的这些成长阵痛,恰恰体现了黄仁勋勇于突破技术边界、而非追求稳妥的经营理念。英伟达现任及前任员工均认为,指望英伟达能精准预判 OpenAI、Meta等客户的规模化部署场景下的芯片性能,本身并不现实。

且有迹象表明,OpenAI 目前已实现英伟达 72 芯组联服务器的规模化使用。本周四,OpenAI 宣布,公司最新的人工智能代码模型 GPT-5.3-Codex 的研发,全程 “由该款专属系统联合设计、提供训练算力并支撑部署运行”。

营收兑现遇阻

据两家云服务商的高管透露,去年全年,芯片部署的延迟令 OpenAI 的部分云服务合作伙伴蒙受了损失 —— 这些企业曾为 Grace Blackwell 芯片投入巨额资金,原本期望芯片能快速上线并收回成本,而云服务商只有在客户开始使用芯片后,才能获得相关收入。

据一名参与相关协商的云服务商高管透露,为缓解资金压力,部分云服务商去年与英伟达协商达成了折扣协议,得以按实际使用量的较小比例支付芯片费用。

另据一名英伟达员工及一名英伟达制造合作伙伴的工作人员透露,英伟达还为部分退回服务器的客户办理了退款。

云服务商推出新技术时,往往需要先承担相关成本,待客户开始使用硬件后才能获得收入,因此这一阶段的利润率通常较低。一份文件显示,在截至去年 8 月的三个月里,甲骨文公司因出租 Blackwell 系列芯片亏损近 1 亿美元,究其原因,是甲骨文完成服务器调试并向客户交付的时间,与 OpenAI 等客户开始使用并支付租金的时间存在明显滞后。

这份为甲骨文云业务高管准备的内部演示文件指出,Grace Blackwell 芯片租赁业务毛利率为负,主要是受 OpenAI 位于得克萨斯州阿比林市的数据中心相关芯片部署问题,以及客户验收周期滞后的影响。

甲骨文此后曾向投资者表示,其人工智能云业务最终将实现 30% 至 40% 的毛利率,这一预期已涵盖数据中心上线前的投入期。

甲骨文的发言人则拒绝就此置评。

踩一下[0]

站长云网

站长云网

顶一下[0]